AI摘要

文章以一次配置未及时生效的雪崩事故切入,剖析Nacos长轮询原理:客户端30s长连接hold,服务端用异步队列+MD5比对即时回推;结合Spring @RefreshScope事件链完成动态刷新。给出调优、重试、灰度、监控、诊断等全套生产级方案,强调“长轮询≠简单轮询”,唯有深研原理与观测体系,才能避免“深夜告警”。

我曾经以为配置中心就是简单的"发布-订阅",直到那个深夜的线上告警——某个核心服务的超时配置没有及时生效,导致整个系统雪崩,我才真正理解长轮询背后的复杂性。

一、从一次配置更新失败的事故说起

1.1 事故现场还原

我们先来看看当时的配置和代码:

# 在Nacos中的服务配置

# Data ID: order-service.yaml

# Group: DEFAULT_GROUP

feign:

client:

config:

default:

connectTimeout: 5000 # 计划从2000改为5000

readTimeout: 10000 # 计划从5000改为10000服务中的配置读取代码:

@RefreshScope

@RestController

@RequestMapping("/orders")

@Slf4j

public class OrderController {

@Value("${feign.client.config.default.connectTimeout:2000}")

private Integer connectTimeout;

@Value("${feign.client.config.default.readTimeout:5000}")

private Integer readTimeout;

@Autowired

private OrderFeignClient orderFeignClient;

@GetMapping("/{orderId}")

public Order getOrder(@PathVariable String orderId) {

log.info("当前超时配置 - connectTimeout: {}, readTimeout: {}",

connectTimeout, readTimeout);

// 这里调用的Feign客户端应该使用上面的超时配置

return orderFeignClient.getOrder(orderId);

}

@PostConstruct

public void init() {

log.info("OrderController初始化完成,超时配置 - connectTimeout: {}, readTimeout: {}",

connectTimeout, readTimeout);

}

}在Nacos控制台修改配置后,监控显示:

23:00:00 - 配置修改

23:00:30 - 服务A配置生效

23:01:15 - 服务B配置生效

23:02:45 - 服务C配置仍未生效 -> 开始出现超时错误

23:05:00 - 手动重启服务C后配置生效问题很明显:不同服务实例的配置刷新时间差异很大,有的实例根本没有及时刷新。

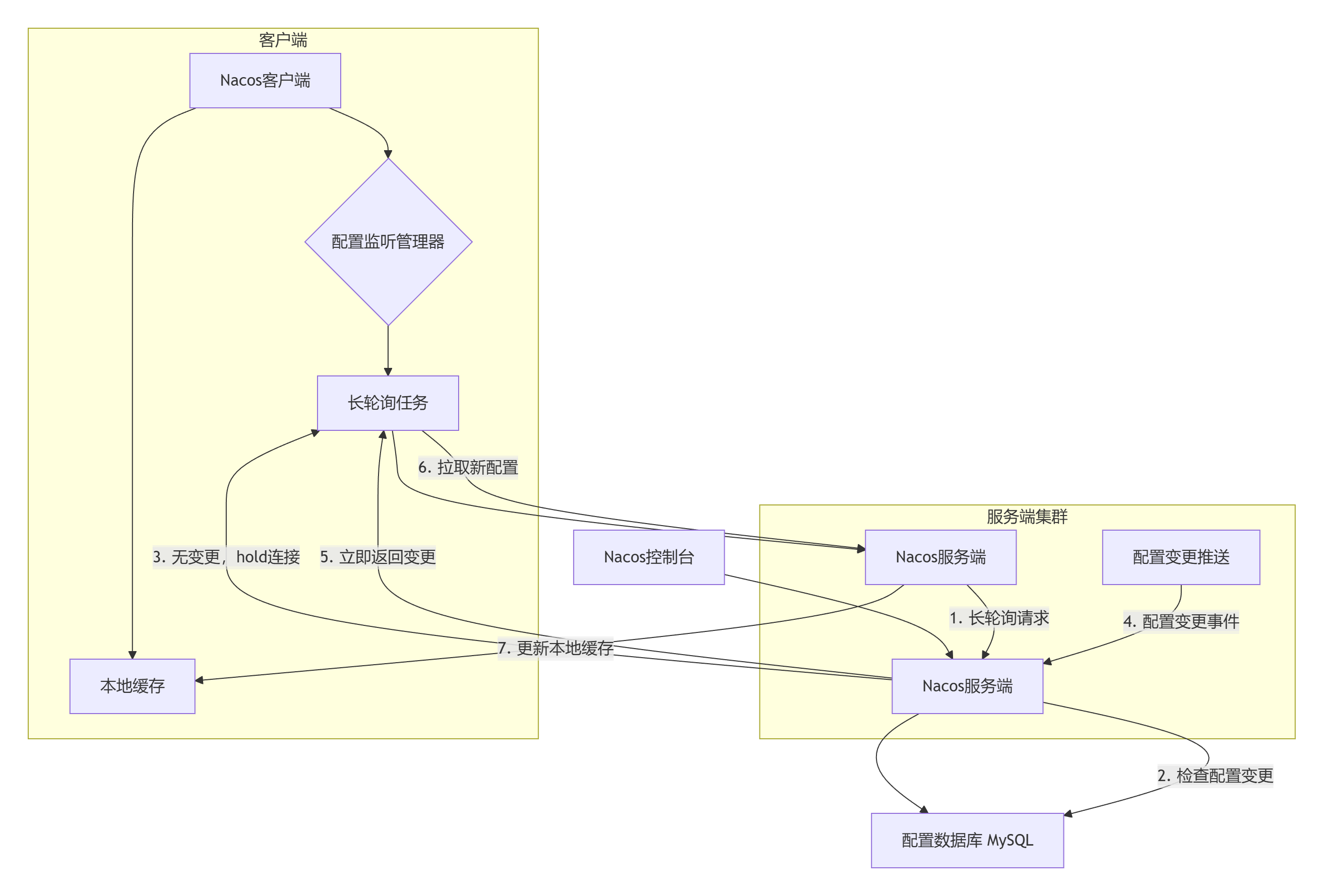

二、Nacos配置中心架构总览

2.1 Nacos配置中心的整体架构

在深入长轮询之前,我们先了解Nacos配置中心的整体架构:

2.2 核心组件解析

// Nacos客户端配置管理的核心类

public class ClientWorker implements Closeable {

// 配置缓存管理器

private ConfigCacheService configCacheService;

// 长轮询管理器

private LongPollingManager longPollingManager;

// 配置监听器

private Map<String, List<ManagerListenerWrap>> listenerMap;

// 执行长轮询任务

public void checkConfigInfo() {

// 这是长轮询的入口

}

}

// 服务端处理长轮询的核心类

@RestController

@RequestMapping("/v1/cs")

public class ConfigController {

@PostMapping("/listener")

public String listener(HttpServletRequest request, HttpServletResponse response) {

// 处理客户端的监听请求

return longPollingService.doPollingConfig(request, response, clientMd5Map, probeRequestSize);

}

}三、长轮询的深度解析

3.1 什么是长轮询?

长轮询是客户端发起请求,服务端如果无变更就保持连接,直到有变更或超时才返回的一种机制。这避免了短轮询的空轮询开销。

传统轮询 vs 长轮询:

// 传统轮询:定时请求

@Scheduled(fixedDelay = 30000) // 每30秒轮询一次

public void traditionalPolling() {

ConfigResponse response = fetchConfigFromServer();

if (response.isChanged()) {

updateConfig(response.getConfig());

}

// 问题:实时性差或服务器压力大

}

// 长轮询:保持连接直到变更或超时

public void longPolling() {

while (!shutdown) {

try {

// 发起长轮询请求,服务端最多hold 30秒

ConfigResponse response = longPollRequest(30000);

if (response.isChanged()) {

updateConfig(response.getConfig());

}

// 立即发起下一次请求

} catch (TimeoutException e) {

// 超时后立即重新发起请求

continue;

}

}

}3.2 Nacos长轮询的实现细节

让我们深入Nacos客户端的实际代码:

public class LongPollingRunnable implements Runnable {

private final String dataId;

private final String group;

private final String tenant;

private final String md5; // 当前配置的MD5值

private final List<ManagerListenerWrap> listeners;

@Override

public void run() {

while (!closed) {

try {

// 检查本地配置是否有变更

if (!checkLocalConfig()) {

// 发起长轮询请求

List<String> changedConfigs = checkUpdateConfigStr(

Arrays.asList(dataId), md5, 30000L);

if (changedConfigs != null && !changedConfigs.isEmpty()) {

// 配置有变更,执行回调

for (String changedDataId : changedConfigs) {

executeListeners(changedDataId);

}

}

}

} catch (Throwable e) {

log.error("长轮询异常", e);

try {

Thread.sleep(3000L); // 异常后等待3秒

} catch (InterruptedException ie) {

Thread.currentThread().interrupt();

}

}

}

}

// 发起长轮询请求

private List<String> checkUpdateConfigStr(List<String> dataIds, String md5,

long timeout) throws IOException {

// 构建请求参数

Map<String, String> params = new HashMap<>();

params.put("Listening-Configs", buildListeningConfigs(dataIds, md5));

// 设置超时时间

HttpRequest request = HttpRequest.newBuilder()

.uri(URI.create(serverAddress + "/v1/cs/configs/listener"))

.timeout(Duration.ofMillis(timeout))

.POST(HttpRequest.BodyPublishers.ofString(""))

.headers(params)

.build();

// 发送请求

HttpResponse<String> response = httpClient.send(request,

HttpResponse.BodyHandlers.ofString());

if (response.statusCode() == 200) {

// 返回发生变更的dataId列表

return parseChangedConfigs(response.body());

} else if (response.statusCode() == 304) {

// 无变更

return Collections.emptyList();

} else {

throw new IOException("长轮询请求失败: " + response.statusCode());

}

}

// 构建监听配置字符串

private String buildListeningConfigs(List<String> dataIds, String md5) {

// 格式: dataId^group^tenant^md5|dataId^group^tenant^md5

StringBuilder sb = new StringBuilder();

for (String dataId : dataIds) {

sb.append(dataId)

.append("^2") // 2表示分隔符

.append(group)

.append("^2")

.append(tenant != null ? tenant : "")

.append("^2")

.append(md5)

.append("|");

}

return sb.toString();

}

}3.3 服务端的长轮询处理

服务端的实现更加复杂,需要管理大量客户端连接:

@Service

public class LongPollingService {

// 所有长轮询请求的队列

private final ConcurrentHashMap<String, Set<ClientLongPolling>> allSubs =

new ConcurrentHashMap<>();

// 处理客户端的监听请求

public String doPollingConfig(HttpServletRequest request,

HttpServletResponse response,

Map<String, String> clientMd5Map,

int probeRequestSize) {

// 1. 立即检查是否有配置变更

List<String> changedGroups = MD5Util.compareMd5(request, response, clientMd5Map);

if (!changedGroups.isEmpty()) {

// 有变更,立即返回

return generateResponse(changedGroups);

}

// 2. 无变更,将客户端加入长轮询队列

String clientIp = getClientIp(request);

ClientLongPolling client = new ClientLongPolling(clientIp, request, response);

// 为每个dataId注册监听

for (String groupKey : clientMd5Map.keySet()) {

allSubs.computeIfAbsent(groupKey, k ->

Collections.newSetFromMap(new ConcurrentHashMap<>()))

.add(client);

}

// 3. 设置异步响应

AsyncContext asyncContext = request.startAsync();

asyncContext.setTimeout(30000L); // 30秒超时

client.setAsyncContext(asyncContext);

// 4. 调度超时任务

scheduler.schedule(() -> {

if (!client.isCompleted()) {

// 超时后移除监听并返回空响应

removeClient(client);

sendResponse(response, "[]"); // 返回空数组表示无变更

}

}, 30000L, TimeUnit.MILLISECONDS);

return null; // 表示请求已进入异步处理

}

// 配置变更时的通知

public void notifyConfigChange(String dataId, String group, String tenant) {

String groupKey = GroupKey.getKey(dataId, group, tenant);

Set<ClientLongPolling> clients = allSubs.get(groupKey);

if (clients != null && !clients.isEmpty()) {

List<String> changedGroups = Collections.singletonList(groupKey);

String responseStr = generateResponse(changedGroups);

// 通知所有监听该配置的客户端

for (ClientLongPolling client : clients) {

client.sendResponse(responseStr);

removeClient(client);

}

}

}

}

// 客户端长轮询连接的封装

class ClientLongPolling {

private final String clientIp;

private final HttpServletRequest request;

private final HttpServletResponse response;

private AsyncContext asyncContext;

private volatile boolean completed = false;

public void sendResponse(String responseStr) {

if (!completed) {

completed = true;

try {

response.getWriter().write(responseStr);

asyncContext.complete();

} catch (IOException e) {

log.error("发送响应失败", e);

}

}

}

}四、配置动态刷新的完整流程

4.1 客户端初始化流程

// Spring Cloud Alibaba Nacos配置刷新的关键类

@Configuration

@EnableConfigurationProperties

public class NacosConfigProperties {

// 长轮询超时时间,默认30秒

private long configLongPollTimeout = 30000L;

// 配置刷新重试间隔

private long configRetryTime = 2000L;

// 最大重试次数

private int maxRetry = 3;

}

// 配置监听管理器

public class NacosContextRefresher {

@Autowired

private ConfigService configService;

@PostConstruct

public void registerNacosListenersForApplications() {

// 为每个配置注册监听器

for (String dataId : getAllDataIds()) {

configService.addListener(dataId, group, new AbstractListener() {

@Override

public void receiveConfigInfo(String configInfo) {

// 配置变更回调

refreshConfigInContext(configInfo);

}

});

}

}

private void refreshConfigInContext(String configInfo) {

// 1. 发布EnvironmentChangeEvent事件

publishEnvironmentChangeEvent();

// 2. 刷新@RefreshScope的Bean

refreshScope.refreshAll();

// 3. 发布RefreshEvent事件

applicationContext.publishEvent(new RefreshEvent(this, null, "Nacos config refresh"));

}

}4.2 配置刷新的事件传播链

当配置变更时,Spring Cloud会触发一系列事件:

// 配置刷新的事件传播

@Component

@Slf4j

public class ConfigRefreshListener {

// 监听EnvironmentChangeEvent

@EventListener

public void onEnvironmentChange(EnvironmentChangeEvent event) {

log.info("环境变量变更: {}", event.getKeys());

// 这里可以执行一些环境变量变更后的逻辑

}

// 监听RefreshEvent

@EventListener

public void onRefresh(RefreshEvent event) {

log.info("配置刷新事件触发");

// 刷新后的处理逻辑

}

// 监听RefreshScopeRefreshedEvent

@EventListener

public void onRefreshScopeRefreshed(RefreshScopeRefreshedEvent event) {

log.info("@RefreshScope Bean已刷新: {}", event.getName());

// @RefreshScope Bean刷新后的逻辑

}

}

// @RefreshScope的实现原理

@Target({ElementType.TYPE, ElementType.METHOD})

@Retention(RetentionPolicy.RUNTIME)

@Scope("refresh")

@Documented

public @interface RefreshScope {

ScopedProxyMode proxyMode() default ScopedProxyMode.TARGET_CLASS;

}

// RefreshScope的实现

public class RefreshScope extends GenericScope {

@Override

public Object get(String name, ObjectFactory<?> objectFactory) {

// 每次获取Bean时检查是否需要刷新

if (isRefreshRequired(name)) {

// 销毁旧的Bean

super.destroy(name);

}

return super.get(name, objectFactory);

}

public void refreshAll() {

// 清除所有Bean缓存,触发重新创建

super.destroy();

}

}五、实战:解决配置更新不及时的问题

5.1 问题定位与解决方案

回到我们开头的事故,经过排查发现问题的根源:

- 客户端长轮询连接断开:某些实例的网络环境不稳定,长轮询连接频繁断开

- 服务端超时时间不一致:客户端和服务端的超时时间配置不一致

- 客户端重试机制不足:连接断开后重试不及时

解决方案:

@Configuration

public class NacosConfigEnhancement {

@Bean

public NacosConfigProperties nacosConfigProperties() {

NacosConfigProperties properties = new NacosConfigProperties();

// 调整长轮询参数

properties.setConfigLongPollTimeout(60000L); // 超时时间从30秒改为60秒

properties.setConfigRetryTime(1000L); // 重试间隔从2秒改为1秒

properties.setMaxRetry(5); // 最大重试次数从3次改为5次

// 启用长轮询健康检查

properties.setEnableRemoteSyncConfig(true);

return properties;

}

@Bean

public NacosConfigManager nacosConfigManager(NacosConfigProperties properties) {

NacosConfigManager manager = new NacosConfigManager(properties);

// 添加长轮询连接监控

manager.addListener(new ConfigServiceListener() {

@Override

public void onConnect(ConfigService configService) {

log.info("Nacos配置服务连接成功");

}

@Override

public void onDisconnect(ConfigService configService) {

log.warn("Nacos配置服务连接断开,尝试重连...");

}

@Override

public void onReconnect(ConfigService configService) {

log.info("Nacos配置服务重连成功");

}

});

return manager;

}

}5.2 增强的重试机制

@Component

@Slf4j

public class EnhancedConfigService {

@Autowired

private ConfigService configService;

private final ScheduledExecutorService scheduler =

Executors.newSingleThreadScheduledExecutor();

private final Map<String, Listener> listenerMap = new ConcurrentHashMap<>();

/**

* 增强的添加监听器方法,包含断线重连机制

*/

public void addListenerWithRetry(String dataId, String group, Listener listener) {

String key = buildKey(dataId, group);

try {

configService.addListener(dataId, group, listener);

listenerMap.put(key, listener);

log.info("配置监听器添加成功,dataId: {}, group: {}", dataId, group);

} catch (NacosException e) {

log.error("添加配置监听器失败,开始重试", e);

scheduleRetry(dataId, group, listener, key, 1);

}

}

/**

* 带指数退避的重试机制

*/

private void scheduleRetry(String dataId, String group,

Listener listener, String key, int retryCount) {

if (retryCount > 5) {

log.error("配置监听器重试次数超限,dataId: {}, group: {}", dataId, group);

return;

}

// 指数退避:1s, 2s, 4s, 8s, 16s

long delay = (long) Math.pow(2, retryCount - 1) * 1000;

scheduler.schedule(() -> {

try {

configService.addListener(dataId, group, listener);

listenerMap.put(key, listener);

log.info("配置监听器重试成功,dataId: {}, group: {}", dataId, group);

} catch (NacosException e) {

log.error("配置监听器重试失败,准备下一次重试", e);

scheduleRetry(dataId, group, listener, key, retryCount + 1);

}

}, delay, TimeUnit.MILLISECONDS);

}

/**

* 手动触发配置刷新

*/

public boolean refreshConfigManually(String dataId, String group) {

try {

String content = configService.getConfig(dataId, group, 5000);

if (content != null) {

// 触发配置变更事件

Listener listener = listenerMap.get(buildKey(dataId, group));

if (listener != null) {

listener.receiveConfigInfo(content);

}

return true;

}

} catch (NacosException e) {

log.error("手动刷新配置失败", e);

}

return false;

}

}六、高级特性:配置灰度发布

6.1 基于Beta测试的配置灰度

@Service

@Slf4j

public class ConfigGrayReleaseService {

@Autowired

private ConfigService configService;

/**

* Beta测试:向特定IP发布配置

*/

public boolean publishBetaConfig(String dataId, String group,

String content, String betaIps) {

try {

// 1. 发布Beta配置

boolean result = configService.publishConfig(dataId, group, content,

ConfigType.PROPERTIES.getType());

if (result) {

// 2. 设置Beta测试的IP

configService.publishBeta(dataId, group, content, betaIps);

log.info("Beta配置发布成功,dataId: {}, betaIps: {}", dataId, betaIps);

return true;

}

} catch (NacosException e) {

log.error("Beta配置发布失败", e);

}

return false;

}

/**

* 监听Beta配置

*/

public void listenBetaConfig(String dataId, String group,

Consumer<String> configConsumer) {

try {

// 获取当前是否为Beta测试

boolean isBeta = configService.isBeta(dataId, group);

if (isBeta) {

// 获取客户端IP

String clientIp = getClientIp();

String betaIps = configService.getBetaIps(dataId, group);

if (betaIps.contains(clientIp)) {

// 当前客户端在Beta测试列表中

String content = configService.getConfig(dataId, group, 5000);

configConsumer.accept(content);

log.info("使用Beta配置,dataId: {}, clientIp: {}", dataId, clientIp);

}

}

} catch (NacosException e) {

log.error("检查Beta配置失败", e);

}

}

}6.2 基于权重的配置灰度

@Component

public class WeightBasedGrayRelease {

private final Random random = new Random();

/**

* 基于权重的配置灰度发布

* @param dataId 配置ID

* @param group 配置分组

* @param oldContent 旧配置

* @param newContent 新配置

* @param weight 灰度权重,0-100

*/

public void grayReleaseByWeight(String dataId, String group,

String oldContent, String newContent,

int weight) {

// 1. 为每个实例计算hash

String instanceId = getInstanceId();

int hash = Math.abs(instanceId.hashCode()) % 100;

// 2. 根据权重决定使用哪个配置

if (hash < weight) {

// 使用新配置

applyNewConfig(dataId, group, newContent);

log.info("实例 {} 使用新配置,hash: {}, weight: {}",

instanceId, hash, weight);

} else {

// 使用旧配置

applyOldConfig(dataId, group, oldContent);

log.info("实例 {} 使用旧配置,hash: {}, weight: {}",

instanceId, hash, weight);

}

// 3. 记录灰度状态

recordGrayStatus(dataId, group, instanceId, hash < weight);

}

/**

* 渐进式灰度发布

*/

public void progressiveGrayRelease(String dataId, String group,

String newContent, int totalSteps) {

for (int step = 1; step <= totalSteps; step++) {

int weight = (step * 100) / totalSteps; // 逐步增加权重

log.info("灰度发布第 {} 步,权重: {}%", step, weight);

grayReleaseByWeight(dataId, group, getCurrentConfig(dataId, group),

newContent, weight);

// 每步之间等待一段时间,观察效果

try {

Thread.sleep(5 * 60 * 1000); // 等待5分钟

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

break;

}

// 检查是否有异常,决定是否继续

if (!checkSystemHealth()) {

log.error("系统健康检查失败,停止灰度发布");

rollbackGrayRelease(dataId, group);

break;

}

}

}

}七、监控与诊断:配置刷新的可观测性

7.1 配置刷新监控

@Component

@Slf4j

public class ConfigRefreshMonitor {

private final MeterRegistry meterRegistry;

// 监控指标

private final Counter configRefreshCounter;

private final Timer configRefreshTimer;

private final Map<String, AtomicInteger> configChangeCounters;

public ConfigRefreshMonitor(MeterRegistry meterRegistry) {

this.meterRegistry = meterRegistry;

this.configChangeCounters = new ConcurrentHashMap<>();

// 初始化指标

this.configRefreshCounter = Counter.builder("nacos.config.refresh")

.description("配置刷新次数")

.register(meterRegistry);

this.configRefreshTimer = Timer.builder("nacos.config.refresh.time")

.description("配置刷新耗时")

.register(meterRegistry);

// 监控长轮询连接

Gauge.builder("nacos.longpolling.connections",

() -> getLongPollingConnectionCount())

.description("长轮询连接数")

.register(meterRegistry);

}

/**

* 监控配置变更事件

*/

@EventListener

public void onConfigChange(EnvironmentChangeEvent event) {

configRefreshCounter.increment();

for (String key : event.getKeys()) {

// 记录每个配置项的变更次数

configChangeCounters

.computeIfAbsent(key, k -> new AtomicInteger(0))

.incrementAndGet();

// 发布到监控系统

meterRegistry.counter("nacos.config.change", "key", key).increment();

log.info("配置项变更: {} = {}", key,

environment.getProperty(key));

}

}

/**

* 监控配置刷新耗时

*/

public void monitorRefreshTime(Runnable refreshTask) {

long startTime = System.currentTimeMillis();

try {

refreshTask.run();

} finally {

long costTime = System.currentTimeMillis() - startTime;

configRefreshTimer.record(costTime, TimeUnit.MILLISECONDS);

if (costTime > 1000) {

log.warn("配置刷新耗时过长: {}ms", costTime);

}

}

}

/**

* 诊断配置刷新问题

*/

public void diagnoseConfigRefresh(String dataId, String group) {

try {

// 1. 检查配置是否存在

boolean exists = configService.getConfigService()

.getServerConfig(dataId, group, 3000L) != null;

// 2. 检查监听器状态

List<Listener> listeners = configService.getListeners(dataId, group);

// 3. 检查最后更新时间

long lastModified = configService.getLastModified(dataId, group);

// 4. 生成诊断报告

Map<String, Object> report = new HashMap<>();

report.put("dataId", dataId);

report.put("group", group);

report.put("exists", exists);

report.put("listenerCount", listeners != null ? listeners.size() : 0);

report.put("lastModified", new Date(lastModified));

report.put("currentTime", new Date());

report.put("timeDiff", System.currentTimeMillis() - lastModified);

log.info("配置刷新诊断报告: {}", JSON.toJSONString(report, true));

} catch (NacosException e) {

log.error("配置刷新诊断失败", e);

}

}

}7.2 长轮询连接健康检查

@Service

@Slf4j

public class LongPollingHealthChecker {

@Autowired

private ConfigService configService;

private final ScheduledExecutorService healthCheckScheduler =

Executors.newSingleThreadScheduledExecutor();

// 健康检查状态

private volatile boolean longPollingHealthy = true;

private volatile long lastSuccessfulPoll = System.currentTimeMillis();

@PostConstruct

public void init() {

// 每30秒执行一次健康检查

healthCheckScheduler.scheduleAtFixedRate(this::checkLongPollingHealth,

0, 30, TimeUnit.SECONDS);

}

/**

* 长轮询健康检查

*/

private void checkLongPollingHealth() {

try {

// 1. 测试配置获取

String testDataId = "health-check-dataId";

String testGroup = "DEFAULT_GROUP";

// 尝试获取一个不存在的配置,测试连接性

String config = configService.getConfig(testDataId, testGroup, 5000);

// 2. 检查最后成功轮询时间

long currentTime = System.currentTimeMillis();

long timeSinceLastSuccess = currentTime - lastSuccessfulPoll;

if (timeSinceLastSuccess > 120000) { // 2分钟无成功轮询

log.error("长轮询可能已停止,最后成功时间: {}ms前", timeSinceLastSuccess);

longPollingHealthy = false;

// 触发告警

triggerAlarm("长轮询健康检查失败",

"长时间未收到配置更新,最后成功时间: " +

new Date(lastSuccessfulPoll));

} else {

lastSuccessfulPoll = currentTime;

longPollingHealthy = true;

}

log.debug("长轮询健康检查通过");

} catch (Exception e) {

log.error("长轮询健康检查失败", e);

longPollingHealthy = false;

// 尝试恢复连接

recoverLongPolling();

}

}

/**

* 恢复长轮询连接

*/

private void recoverLongPolling() {

log.info("尝试恢复长轮询连接");

try {

// 1. 重新初始化ConfigService

configService.addListener("test-dataId", "DEFAULT_GROUP",

new AbstractListener() {

@Override

public void receiveConfigInfo(String configInfo) {

// 监听恢复

longPollingHealthy = true;

lastSuccessfulPoll = System.currentTimeMillis();

log.info("长轮询连接恢复成功");

}

});

// 2. 立即触发一次配置检查

configService.getConfig("test-dataId", "DEFAULT_GROUP", 5000);

} catch (NacosException e) {

log.error("恢复长轮询连接失败", e);

}

}

/**

* 获取健康状态

*/

public boolean isLongPollingHealthy() {

return longPollingHealthy;

}

/**

* 获取最后成功轮询时间

*/

public long getLastSuccessfulPoll() {

return lastSuccessfulPoll;

}

}八、经验总结与最佳实践

8.1 长轮询的关键参数调优

# application.yml

spring:

cloud:

nacos:

config:

# 长轮询超时时间,建议30-60秒

long-poll-timeout: 30000

# 配置重试时间,建议1-3秒

config-retry-time: 2000

# 最大重试次数,建议3-5次

max-retry: 3

# 启用远程同步配置

enable-remote-sync-config: true

# 扩展配置

extension-configs:

- data-id: shared-config.yaml

group: SHARED_GROUP

refresh: true # 是否动态刷新8.2 配置刷新的最佳实践

配置项的设计原则:

- 频繁变化的配置和稳定配置分离

- 按业务域划分配置,避免配置爆炸

- 重要配置添加版本控制和变更日志

客户端优化建议:

- 合理设置长轮询超时时间,避免频繁重建连接

- 实现客户端本地缓存,防止配置中心不可用时服务不可用

- 添加配置变更的监控和告警

服务端优化建议:

- 合理设置服务端的连接超时和线程池大小

- 监控长轮询连接数,防止连接泄漏

- 定期清理过期的长轮询连接

8.3 故障排查指南

当配置刷新出现问题时,可以按照以下步骤排查:

@Component

@Slf4j

public class ConfigRefreshTroubleshooter {

@Autowired

private ConfigService configService;

@Autowired

private Environment environment;

/**

* 配置刷新问题排查

*/

public void troubleshoot(String dataId, String group) {

log.info("开始排查配置刷新问题,dataId: {}, group: {}", dataId, group);

// 1. 检查配置是否存在

checkConfigExists(dataId, group);

// 2. 检查监听器状态

checkListenerStatus(dataId, group);

// 3. 检查网络连接

checkNetworkConnectivity();

// 4. 检查客户端配置

checkClientConfiguration();

// 5. 检查服务端日志

checkServerLogs(dataId, group);

log.info("配置刷新问题排查完成");

}

private void checkConfigExists(String dataId, String group) {

try {

String content = configService.getConfig(dataId, group, 5000);

if (content == null) {

log.error("配置不存在,dataId: {}, group: {}", dataId, group);

} else {

log.info("配置存在,内容长度: {}", content.length());

}

} catch (NacosException e) {

log.error("获取配置失败", e);

}

}

private void checkListenerStatus(String dataId, String group) {

try {

List<Listener> listeners = configService.getListeners(dataId, group);

log.info("配置监听器数量: {}", listeners.size());

for (int i = 0; i < listeners.size(); i++) {

Listener listener = listeners.get(i);

log.info("监听器 {}: {}", i, listener.getClass().getName());

}

} catch (Exception e) {

log.error("检查监听器状态失败", e);

}

}

private void checkClientConfiguration() {

log.info("客户端配置检查:");

log.info("- spring.cloud.nacos.config.server-addr: {}",

environment.getProperty("spring.cloud.nacos.config.server-addr"));

log.info("- spring.cloud.nacos.config.namespace: {}",

environment.getProperty("spring.cloud.nacos.config.namespace"));

log.info("- spring.cloud.nacos.config.refresh-enabled: {}",

environment.getProperty("spring.cloud.nacos.config.refresh-enabled"));

}

}总结

通过深入分析Nacos的长轮询机制,我们可以得出以下关键结论:

- 长轮询是实时性的保证:通过保持连接而不是频繁轮询,既减少了网络开销,又保证了配置变更的实时性

- 客户端重试机制至关重要:网络不稳定的情况下,完善的重试机制是配置刷新的可靠保障

- 监控和诊断不可或缺:没有监控的配置中心就像盲人摸象,必须建立完善的监控体系

- 灰度发布能力是生产必备:直接全量更新配置风险太大,必须支持灰度发布

最重要的收获:配置中心不是简单的键值存储,而是一个复杂的分布式系统。理解其工作原理,合理配置参数,建立完善的监控和故障排查机制,才能在生产环境中稳定使用。

这次事故让我深刻认识到,技术工具的使用不仅要知道"怎么用",更要理解"为什么这样设计"。只有深入理解底层原理,才能在出现问题时快速定位和解决,这也是中级开发者向高级开发者迈进的关键一步。