AI摘要

一台小小的树莓派,一段Python脚本,每天清晨为你准时奉上百度最热门的新闻摘要

项目起源:一个简单的需求

在信息爆炸的时代,每天打开浏览器首页,总会被琳琅满目的新闻标题淹没。我发现自己常常在寻找真正值得关注的热点新闻上浪费了大量时间。于是产生了一个想法:能否让技术为我筛选和整理这些信息,每天定时将百度首页的热点新闻推送到我的邮箱?

硬件基础:树莓派作为24小时运行平台

我选择了树莓派作为这个自动化任务的运行平台。这个小巧而强大的单板电脑不仅功耗低,而且能够稳定地24小时运行,是家庭自动化项目的理想选择。

图:部署项目的树莓派4B,配备透明外壳和主动散热风扇,确保长时间稳定运行

上图展示的就是我的树莓派开发环境。设备装在一个透明的保护壳内,方便观察运行状态,同时安装了风扇确保散热。树莓派的低功耗特性意味着它可以持续运行而不必担心电费问题,这正是自动化任务所需的基础设施。

技术实现:Python脚本解析百度首页

核心的脚本逻辑其实并不复杂,但需要处理几个关键环节:

1. 网络请求与内容抓取

脚本首先会检查网络连接状态,然后向百度首页发送HTTP请求。通过状态码200确认连接正常后,获取完整的HTML页面内容并保存为本地文件,这既是为了调试方便,也作为原始数据的备份。

2. 新闻内容提取

这是项目的核心部分。百度首页的热点新闻通常有特定的HTML结构和CSS类名,通过分析页面DOM,我定位到热点新闻的容器元素,然后提取其中的新闻标题和链接。

# 简化的提取逻辑示意

def extract_hot_news(html_content):

soup = BeautifulSoup(html_content, 'html.parser')

news_items = soup.select('.hotnews-item') # 根据实际结构调整选择器

news_list = []

for item in news_items[:10]: # 只取前10条热点

title = item.select_one('.title').text.strip()

link = item.select_one('a')['href']

news_list.append({'title': title, 'link': link})

return news_list3. 邮件封装与发送

提取到的新闻列表会被格式化为适合阅读的HTML邮件内容,每条新闻都包含序号、标题和指向原文的链接。邮件配置信息(如SMTP服务器、端口、认证信息)存储在独立的配置文件中,避免将敏感信息硬编码在脚本里。

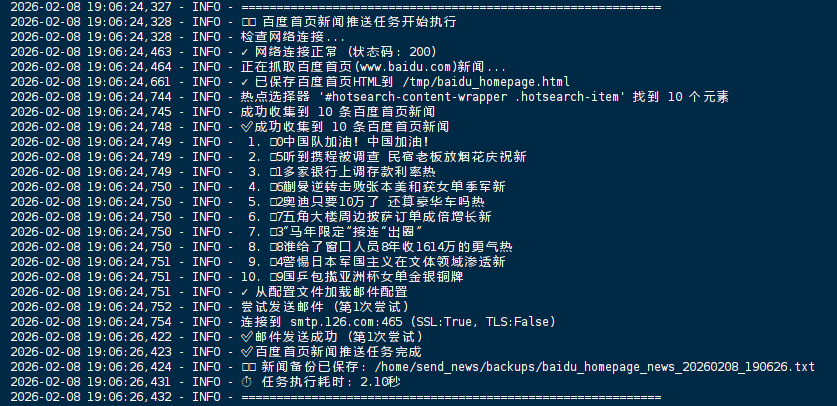

运行过程:清晰的日志记录

良好的日志记录是自动化脚本维护的关键。我的脚本在每个关键步骤都会输出详细的日志信息,方便追踪执行情况和排查问题。

图:脚本执行日志,清晰记录了从网络请求到邮件发送的完整流程,总耗时仅2.10秒

从上图的日志可以看到,整个流程包括:

- 网络连接检查(状态码200表示成功)

- 百度首页抓取与保存

- 热点新闻提取(共提取10条)

- 邮件配置加载与发送

- 新闻备份保存

整个过程仅耗时2.10秒,效率相当高。这样的轻量级操作确保了对树莓派资源的低消耗。

成果展示:清爽的新闻邮件

每天早上,我的收件箱都会准时收到这样一封格式清晰的新闻摘要邮件:

图:每日收到的新闻邮件,每条新闻都有序号、标题和直接访问链接

邮件的设计遵循简洁实用的原则:

- 每条新闻都有醒目的蓝色序号标记

- 新闻标题清晰突出

- 明确标注新闻来源为"百度首页"

- 每条新闻都附带"查看详情"链接,点击即可跳转原文

- 邮件底部注明发送时间和技术支持信息,体现自动化特性

目前提取的是排名前10的热点新闻,这个数量经过实践验证,既不会信息过载,又能覆盖当天最重要的新闻事件。

定时执行:Cron任务的配置

为了让脚本每天自动运行,我在树莓派上配置了Cron定时任务:

# 每天上午8点执行新闻推送

0 8 * * * cd /home/send_news && /usr/bin/python3 baidu_homepage_news.py >> /home/send_news/logs/news.log 2>&1这样的配置确保无论我是否在电脑前,都能准时收到当天的新闻摘要。通过日志重定向,所有运行记录都会保存到指定文件,方便后期查看和分析。

遇到的问题与解决方案

在开发过程中,我遇到了一些典型的挑战:

1. 网页结构变化

百度首页的HTML结构偶尔会更新,导致选择器失效。解决方案是在脚本中加入结构验证逻辑,如果新闻提取失败,会发送警报邮件通知我手动检查和调整选择器。

2. 网络波动问题

树莓派通过家庭WiFi连接网络,偶尔会有连接不稳定的情况。我在脚本开始时加入了网络连通性检查,如果首次连接失败,会等待30秒后重试,最多尝试3次。

3. 邮件发送限制

部分邮件服务商对自动化发送有限制。我选择了支持SMTP的服务商,并在脚本中合理控制了发送频率和内容格式,避免被识别为垃圾邮件。

项目扩展可能性

这个基础项目有几个自然的扩展方向:

- 多平台支持:除了百度,还可以整合其他新闻源

- 个性化筛选:根据关键词或主题筛选特定类型的新闻

- 多接收方式:除了邮件,还可以集成到即时通讯工具如微信、Telegram

- 摘要生成:结合简单的NLP技术,为长篇新闻生成简短摘要

总结:小硬件,大便利

这个项目再次验证了树莓派在家庭自动化中的价值。只需几十瓦的功耗,它就能稳定地执行各种定时任务,将我们从重复性工作中解放出来。

整个项目的代码量不大,但完整地涵盖了网络请求、数据解析、邮件发送等多个实用技能点。对于Python初学者来说,这是一个很好的综合性练习项目;对于有经验的开发者,则展示了如何将简单想法转化为实用工具的过程。

最重要的是,这个项目解决了一个真实的需求。每天早上打开邮箱,看到整理好的新闻摘要,我能够迅速了解当天的重要事件,而不会在信息海洋中迷失方向。这种'技术服务于生活'的体验,正是编程最吸引人的地方之一。

技术栈总结:

- 硬件:树莓派4B + 主动散热外壳

- 开发语言:Python 3

- 主要库:Requests(网络请求)、BeautifulSoup(HTML解析)、smtplib(邮件发送)、logging(日志记录)

- 部署:Linux Cron定时任务

- 数据源:百度首页热点新闻

项目源码:https://github.com/huangleicole/raspberry-pi-baidu-news-crawler

通过这个项目,我不仅获得了实用的新闻推送工具,更深入理解了网络爬虫、自动化任务和家庭服务器部署的整个流程。希望我的经验能为你提供一些启发,也许下一个便利的自动化工具,就诞生在你的树莓派上。